Успех онлайн-бизнеса напрямую зависит от видимости сайта в поисковых системах. Ключевым фактором является индексация веб-страниц — процесс, при котором поисковые роботы непрерывно сканируют его контент, включая текст, изображения и видео, для последующего добавления в базу данных поисковой системы. Чем качественнее индексация вашего сайта, тем выше его ранжирование в поисковых системах по соответствующим запросам.

Как узнать, индексируется ли ваш сайт

Самый простой способ проверить индексацию — выполнить поиск по сайту в соответствующей поисковой системе. Если страницы присутствуют в выдаче, значит, они проиндексированы.

Причин, почему сайт не индексируется Гуглом, очень много. Рассмотрим основные из них.

Файл Robots.txt

Разработчики хранят тестовую версию сайта на отдельных доменах. И чтобы она не индексировалась, используют файл robots.txt. Если по завершению работ в файл не вносятся изменения, то Google не индексирует сайт, так как содержимое тестовой версии попадает на рабочий домен вместе с запретом на индексацию в robots.txt.

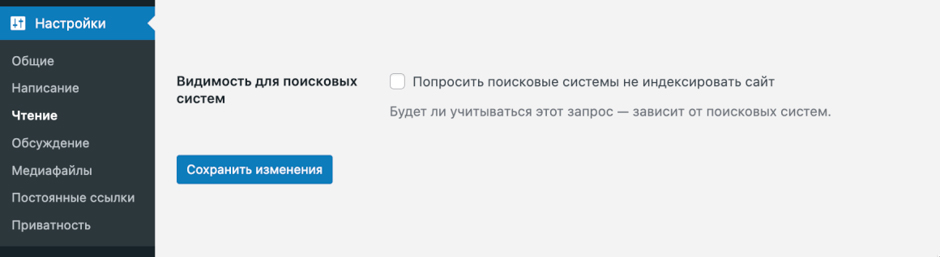

Увидеть, допущена ли такая ошибка, можно в настройках индексации в панели управления ресурсом (если сайт на CMS WordPress). Для этого нужно зайти в раздел «Настройки», далее — в подраздел «Чтение». Здесь будет поле «Видимость для поисковых систем» — оно должно быть пустым. Также можно воспользоваться специальными инструментами, о которых мы расскажем далее.

Проверяем файл Robots.txt

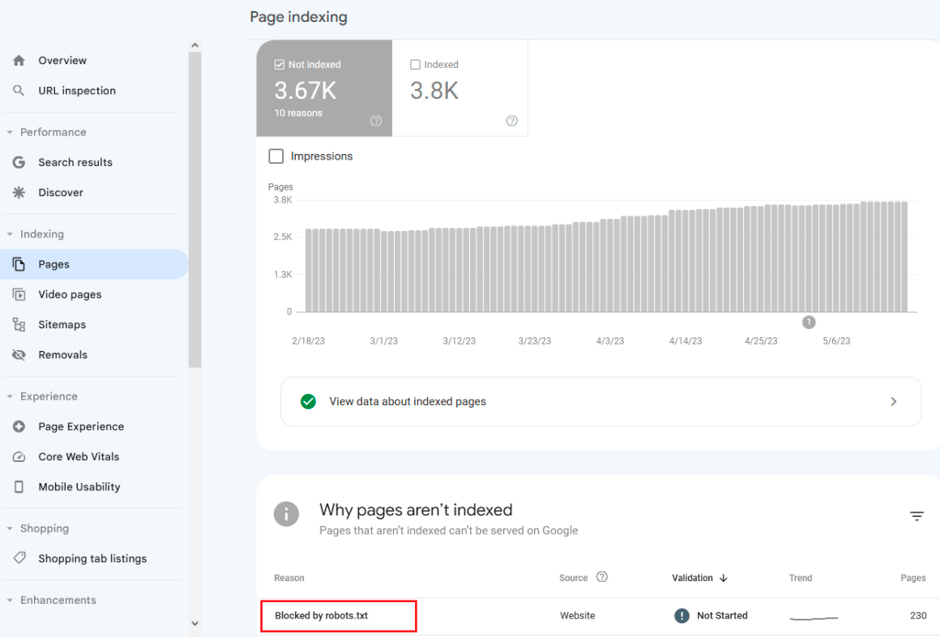

Чтобы разобраться, почему Гугл не индексирует сайт, используйте Google Search Console — бесплатный инструмент для веб-мастеров. Чтобы начать пользоваться сервисом, вам понадобится аккаунт в Google. Алгоритм довольно простой: перейдите в раздел «Индексирование», далее — «Страницы». Здесь вы увидите, какие файлы robots.txt были найдены на вашем сайте.

Метатеги Robots

Еще одна распространенная причина, почему сайт не индексируется в Google, — это метатег Robots. Он сообщает поисковым роботам о том, что индексировать страницу не нужно. В ее коде метатег может выглядеть следующим образом:

<meta name=“robots” content=“noindex”>

Проверяем метатег Robots

Сделать это можно с помощью Google Search Console. В разделе «Индексирование» вы найдете подраздел «Страницы» и далее таблицу «Почему эти страницы не индексируются».

Также для поиска метатегов Robots можно использовать специальные программы, например, Screaming Frog SEO Spider или Netpeak Spider.

Файл .htaccess

Он позволяет управлять различными настройками и функциями сервера на уровне отдельных каталогов или целого веб-сайта. И если в этом файле прописаны запрещающие правила, то сайт индексироваться не будет. Как правило, файл располагается в корневой директории ресурса или в любом из его подкаталогов.

Тег Rel Canonical

Тег является элементом HTML, который используется для указания основного URL-адреса страницы. Его использование помогает избежать проблем с дублированием контента и способствует более эффективному ранжированию страниц в результатах поиска. Но также его использование может стать причиной, почему сайт не индексируется в Google, например, если тег используется некорректно.

Проверяем наличие тегов rel=”canonical”

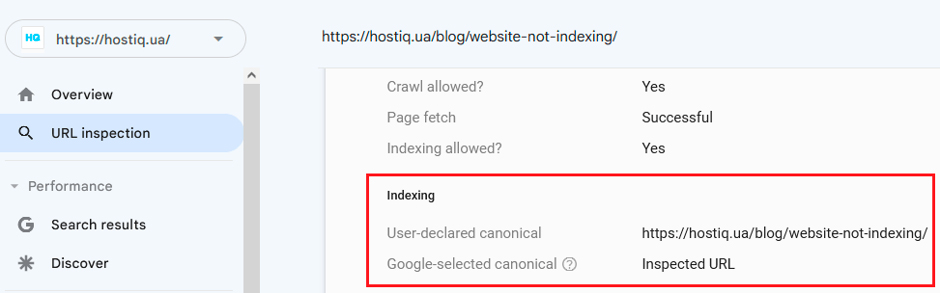

В Google Search Console информация об этом теге находится в разделе «Проверка URL».

Также узнать, использовался ли тег, можно с помощью платных программ Screaming Frog, Netpeak Spider и прочих.

X-Robots-Tag

Это HTTP-заголовок, который предоставляет инструкции для поисковых ботов о том, как обрабатывать содержимое страницы. Значения X-Robots-Tag могут включать разные директивы. В частности, noindex — причина, по которой сайт не индексируется Гуглом.

Проверяем наличие X-Robots-Tag на страницах сайта

Можно использовать плагин Web Developer, который доступен для большинства популярных браузеров. В разделе Information или Headers вы найдете информацию о заголовках HTTP, включая X-Robots-Tag.

Также можно использовать инструменты для аудита сайтов Screaming Frog и Netpeak Spider. После завершения этого процесса вы найдете информацию о X-Robots-Tag.

Долгий ответ сервера

Время ответа сервера — это интервал, за который запрос от клиента в браузере достигает сервера, а клиент получает ответ. Согласно рекомендациям Гугл, время отклика не должно превышать 500 миллисекунд, а в идеале — быть менее 200 миллисекунд. Очень важно следить за тем, чтобы ответ не был долгим, ведь это одна из распространенных причин, почему Google не индексирует сайт в полной мере.

Проверяем время ответа сервера

WebPageTest — это мощный инструмент для тестирования производительности веб-сайтов. Он позволяет измерить скорость загрузки страницы с разных мест и на разных устройствах. Просто введите URL вашей страницы на сайте WebPageTest, выберите местоположение и браузер, а затем запустите тест. Вы получите подробный отчет о времени загрузки, компонентах страницы (DNS, TCP, TLS и другие), а также рекомендации по оптимизации.

Еще один бесплатный инструмент для проверки производительности веб-страниц — это GTmetrix. С его помощью вы можете проверить, как ваша страница загружается на разных устройствах. Также мгновенно проверить скорость загрузки вашей страницы можно с помощью сервиса Dotcom-Tools. Введите URL, и вы получите подробный график времени загрузки элементов страницы.

Почему сервер может долго отвечать

Существует несколько распространенных причин, которые могут привести к замедлению загрузки страниц и снижению производительности сайта.

- Ограниченные ресурсы сервера. Это особенно актуально для высоконагруженных ресурсов или сайтов с большим количеством динамического контента.

- Неоптимизированная настройка сервера. Неправильная конфигурация веб-сервера, базы данных или других компонентов системы может приводить к неэффективному использованию ресурсов и, как следствие, к снижению производительности.

- Отсутствие оптимизации клиентской части. Неоптимизированные файлы CSS, JavaScript и изображения увеличивают размер страницы и время ее загрузки.

- Отсутствие кэширования. Кэширование статических ресурсов (CSS, JavaScript, изображений) и динамического контента на стороне сервера и клиента позволяет снизить нагрузку на нього и ускорить загрузку повторно посещаемых страниц.

- Неоптимизированные запросы к базе данных. Избыточные запросы могут замедлять генерацию динамического контента и увеличивать время ожидания для пользователей.

Для обеспечения оптимальной скорости загрузки сайта рекомендуется регулярно проводить аудит и оптимизацию на всех уровнях.

Неверный ответ сервера

Также важно регулярно проверять коды ответа сервера, чтобы убедиться, что ваш сайт функционирует корректно и пользователи могут успешно получать доступ к контенту. Код 200 указывает на то, что страница доступна на сервере и успешно загружается. Если вы получаете другой код, это свидетельствует об ошибках в нем, например, 404 (страница не найдена) или 500 (внутренняя ошибка сервера). И это одна из причин, почему сайт не индексируется в Гугле.

Проверяем ответ сервера

Есть несколько способов, как это можно сделать.

- Google Search Console. Этот бесплатный инструмент от Google поможет вам отслеживать состояние вашего сайта.

- httpstatus.io. Этот онлайн-сервис позволяет быстро проверить коды ответа сервера для конкретных URL-адресов.

- Netpeak Spider и Screaming Frog. Эти программы предоставляют более подробные анализы вашего сайта.

Также вы можете установить специальные плагины для браузеров. Просто откройте страницу, нажмите F12, перейдите на вкладку Network, обновите страницу и посмотрите коды ответа для каждого ресурса.

Нестабильная работа хостинга или сервера

Владельцам веб-ресурсов крайне важно обеспечить надежность используемого хостинга и стабильность серверной инфраструктуры, так как нестабильная работа приводит к тому, что Google не индексирует страницы. Для контроля доступности сайта существует множество специализированных сервисов, известных как uptime checkers. Введя соответствующий поисковый запрос, вы получите обширный список инструментов, позволяющих отслеживать стабильность работы хостинга и своевременно выявлять любые перебои.

Проблемы с AJAX/JavaScript

Давайте подробнее рассмотрим, какие проблемы могут возникнуть.

- Задержка индексации. Если ваш контент полностью зависит от клиентской обработки (так называемого Client-Side Rendering), это может привести к задержкам в индексации. Например, Google может видеть пустой экран, пока JavaScript не «отрисует» контент.

- Проблемы с динамическим контентом. Индексация не будет осуществляться, если поисковые системы не могут интерпретировать контент или получить к нему доступ.

- Недоступность контента. Если JavaScript не поддерживается или не распознается поисковыми роботами, Гугл не индексирует сайт.

- Проблемы с навигацией. Использование AJAX может привести к сложностям с навигацией на вашем сайте. Например, навигационные элементы могут не работать должным образом.

Чтобы минимизировать эти проблемы, используйте универсальные фреймворки или Server-Side Rendering (SSR). Также избегайте скрытия важного контента за JavaScript, особенно на первоначальной загрузке страницы.

Контент низкого качества

Существует такое понятие как thin content (пустой или низкокачественный контент), которое относится к веб-страницам, лишенным ценности для пользователей.

К такому контенту относятся:

- материалы, полностью или частично скопированные с других источников;

- идентичная информация, размещенная на нескольких страницах вашего сайта или на других ресурсах;

- сгенерированный программным путем контент, лишенный смысла и логики;

- неинформативные страницы с партнерскими ссылками;

- страницы, созданные исключительно для перенаправления пользователей на другие ресурсы.

Поисковые системы стремятся предоставлять релевантные и полезные результаты, поэтому Google не индексирует страницы или же они ранжируются намного ниже.

Ранее забаненный домен

Google поддерживает черные списки доменов, которые были забанены или имели проблемы в прошлом. Если ваш домен находится в таком списке, это ответ на вопрос, почему сайт не индексируется в Google.

Если вы приобрели ранее забаненный домен, важно предпринять шаги для восстановления его репутации. Убедитесь, что весь контент на нем соответствует стандартам Google и не нарушает правила. И после этого отправьте запрос на рассмотрение через Google Search Console.

Отсутствие Sitemap на сайте

Sitemap или карта сайта представляет собой структурированный файл, содержащий список всех доступных страниц вашего сайта с их URL-адресами. И ее отсутствие — также одна из причин, по которой не индексируется сайт в Google. Без карты поисковый робот может случайным образом проиндексировать лишь несколько страниц. И если значительная часть веб-страниц останется неиндексированной, это негативно скажется на видимости сайта в поисковой выдаче.

Создание карты сайта — это относительно простой процесс, который можно выполнить вручную или с помощью специализированных инструментов и плагинов.

Бесконечный цикл переадресации

Зачастую эта проблема возникает из-за банальной опечатки или ошибки в настройках перенаправлений, но решить ее можно достаточно просто. Если ваш сайт работает на WordPress, инструмент .htaccess может помочь обнаружить страницы, с которых происходит перенаправление трафика. Достаточно выполнить в нем поиск по ключевому слову Redirect 301, чтобы найти все файлы с перенаправлениями. После этого внимательно проверьте их на наличие опечаток или ошибок и исправьте. Если вы обнаружите временные перенаправления (302 редирект), рекомендуется заменить их на постоянные (301 редирект).

Также можно использовать такой инструмент, как Screaming Frog. Он позволяет провести глубокий анализ сайта и обнаружить любые ошибки, из-за которых не индексируется сайт в Google. После устранения всех выявленных проблем рекомендуем повторно отправить запрос на индексацию вашего сайта через Google Search Console. Обычно процесс повторной индексации занимает около семи дней, после чего ваш веб-ресурс должен корректно индексироваться поисковыми системами.

Отсутствие всех вариантов домена в Google Search Console

При переходе на HTTPS поисковые системы воспринимают HTTP и HTTPS версии сайта как два отдельных ресурса. Если вы не верифицируете обе версии в Search Console, Гугл не индексирует новые страницы, и тогда могут возникнуть проблемы с дублированием контента и передачей ссылочного веса между страницами.

Для предотвращения таких ситуаций необходимо добавить и верифицировать оба варианта домена (HTTP и HTTPS) в Search Console. Это позволит Google правильно распознавать и обрабатывать ваш сайт, независимо от используемого протокола.

Проблемы со стороны поисковиков

Причины, почему Гугл не индексирует страницы, могут быть связаны с работой самих поисковых систем. Временные сбои, перегрузки или другие проблемы могут временно повлиять на способность поисковых роботов индексировать веб-ресурсы. Если вы столкнулись с проблемами индексации, которые, по вашему мнению, связаны с работой поисковых систем, рекомендуем обратиться в службу поддержки.

Заключение

Без адекватной индексации веб-ресурса любые попытки продвижения в поисковых системах обречены на провал. Поэтому отслеживание этого процесса критически важно для успешного роста вашего онлайн-бизнеса. Постоянный мониторинг индексации и своевременная оптимизация контента позволят вам занять лидирующие позиции в поисковой выдаче и привлечь целевой трафик на ваш сайт.

FAQ

Почему сайт не индексируется в Гугле?

Причин, почему это происходит, может быть несколько.

- Новый сайт. Гугл может не успеть проиндексировать новый сайт в течение нескольких недель или месяцев после создания.

- Проблемы с доступом. Если у роботов поисковых систем есть проблемы с доступом к сайту, например, из-за ошибок в файле robots.txt или неправильной настройки серверов, то индексация будет затруднена.

- Низкое качество контента. Сайты с некачественным, дублированным или малозначимым контентом могут быть проигнорированы поисковой системой.

- Проблемы с внутренней перелинковкой. Если страницы сайта слабо связаны между собой, то часть из них может быть не проиндексирована.

- Санкции поисковых систем. В случае нарушения веб-мастером правил поисковых систем, например, из-за попытки обмана алгоритмов, сайт может быть исключен из индекса полностью.

Почему не индексируются страницы сайта?

Отдельные страницы сайта могут не индексироваться по следующим причинам:

- Закрытие от индексации в robots.txt. Если страницу закрыть в файле robots.txt, то поисковики ее проигнорируют.

- Отсутствие внутренних ссылок. Если на страницу не ведут внутренние ссылки с других страниц сайта, то ее сложно будет обнаружить роботам.

- Дублированный контент. Страницы с контентом, полностью продублированным с других ресурсов, могут быть проигнорированы.

- Технические ошибки. Коды ошибок сервера, например, 404 и 500, не позволяют проиндексировать страницу.

- Низкое качество контента. Страницы с малозначимым текстовым наполнением могут игнорироваться поисковиками.

Как часто Гугл индексирует сайт?

В среднем полная переиндексация актуальных сайтов происходит раз в несколько недель или месяцев. Однако новые и часто обновляемые страницы могут быть проиндексированы за несколько дней или даже часов после публикации. Частота переиндексации зависит от авторитетности сайта, периода обновления контента, технических ограничений ресурса и других факторов.

Оставьте ваши контактные данные.

Будем рады обсудить ваш проект!